오픈클로(Openclaw)를 설치하고 세팅하면서 겪은 시행착오를 정리했다. 나 역시 세팅 과정에서 인터넷에 올라온 다른 사람들의 짧은 경험담이나 댓글이 큰 도움이 되었다. 이 글도 누군가에게는 그런 도움이 되길 바라는 마음으로 작성한다.

이 글의 핵심은 오픈클로에 사용할 LLM 모델 선택에 관한 이야기다. 가성비 좋은 모델을 찾아 헤매던 나의 여정과, 최종적으로 z.ai의 GLM-4.7 모델로 정착하기까지의 과정을 공유하고자 한다.

목차

오픈클로와의 첫 만남

지난주 주말, 오픈클로(Openclaw)라는 것을 알게 되었다. 몰트북이라는 AI 전용 커뮤니티가 화제가 되면서 오픈클로도 함께 유명해진 것 같다. “AI가 스스로 생각하고 의견을 쓰고 종교를 만든다”는 식의 흥미로운 이야기들이 사람들의 관심을 끌었다.

참고로 이름이 조금 헷갈릴 수 있는데, 처음에는 ‘클로드봇’이라는 이름으로 시작했고, 이후 ‘몰트봇’으로 변경되었다가 현재는 ‘오픈클로’로 최종 정착했다.

내가 관심을 가진 부분은 AI가 내 명령에 따라 직접 PC를 제어할 수 있다는 점이었다. 상상한 것은 간단했다. 내가 외출해 있을 때 집에 있는 PC에게 작업을 시키고 보고를 받는 것. 인터넷을 검색해서 필요한 자료를 수집하게 하거나, 초안만 작성해놓은 엑셀 파일의 남은 부분을 완성시키는 것 같은 작업 말이다.

일단 이런 상상만으로도 충분히 체험해볼 가치가 있다고 판단했다.

설치 과정과 환경 세팅

인터넷을 조금 뒤지니 설치 가이드가 있는 한국어 블로그 글들이 있었다. 다만 주의할 점이 있었다. 오픈클로는 PC에 많은 접근 및 제어 권한을 가지기 때문에, 개인 정보가 있을 수 있는 주 PC가 아닌 별도의 PC에 설치하라는 경고가 많이 보였다.

처음에는 Docker에 설치를 시도했다. 그런데 Docker 환경은 신경 써야 할 게 더 많고 불편했다. 결국 집에서 잘 사용하지 않는 Windows 11이 설치된 노트북에 오픈클로를 설치했다. 이게 지금까지 사용하는 최종 세팅이다.

핵심은 LLM 모델 선택

여기서부터가 이 글의 핵심이다. 오픈클로는 그저 몸체일 뿐이고, 각종 작업을 수행하기 위해서는 두뇌인 LLM이 필요하다. LLM을 사용하는 방법은 크게 두 가지다.

1. 로컬에서 직접 LLM 모델 구동

직접 PC에서 LLM 모델을 돌리려면 그에 맞는 사양의 PC가 필요하다. 특히 그래픽카드의 VRAM 용량이 중요하다. VRAM이 클수록 더 고성능 모델을 구동할 수 있다.

문제는 VRAM 용량이 큰 그래픽카드는 가격이 비싸고 전력 소모도 크다는 것. 이것이 요즘 맥미니 품절 사태의 원인 중 하나로 보인다. 맥미니는 전력 소모가 적고, 시스템 메모리를 VRAM으로 사용할 수 있도록 통합되어 있다. 또한 그래픽카드 전용 메모리보다는 느리지만 일반 PC 메모리보다는 훨씬 빠르다. 로컬 모델을 돌리기에 적합한 구조인 셈이다.

나도 중고 맥미니 구입을 심각하게 고민했다. 하지만 결론은 이랬다. 아주 비싼 고사양 맥미니가 아니라면 로컬에서 모델을 돌리는 건 비추천. 8GB, 16GB 메모리를 가진 기본형 맥미니로는 쓸 만한 성능의 LLM을 돌릴 수 없다. 모델 성능이 너무 떨어지면 오픈클로를 제대로 사용할 수 없다. (8GB, 16GB 맥미니는 뒤에 후술하는 저성능 LLM보다 더 낮은 성능의 모델만 구동 가능)

로컬 모델의 장점은 초기 투자비용은 크지만 이후 유지비가 적게 든다는 것이다. 전기세 정도만 부담하면 되고, 내가 직접 관리하는 모델이다 보니 보안 관련 걱정도 줄어든다.

2. API를 통해 LLM 모델 호출

다음 방법은 OpenAI 같은 회사에서 제공하는 GPT 모델을 유료로 사용하는 것이다. 걱정되는 건 역시 비용이다. 모델을 호출할 때마다 비용이 발생하다 보니 사용할 때마다 비용 걱정이 따라온다.

무료 모델을 찾아서

웹을 찾아보니 무료 모델을 사용할 수 있는 방법들이 있어서 이 방법으로 시작했다.

Gemini 모델 시도

첫 번째 방법은 구글의 Gemini 모델 사용이었다. 나는 이미 Gemini-CLI를 쓰기 위해 사용하던 API 키가 있었다. 오픈클로를 설치하고 추천 모델을 따라 Gemini-3-flash-preview 모델을 연결했다.

처음에는 너무 잘 작동했다. 신기했다. 사용 모델을 다른 것으로 바꿔달라고 요청하자 스스로 모델을 교체하려고 시도했다. 그런데 무료 사용량이 초과되어 결국 작업은 실패했다. 무료 사용량이 오픈클로를 사용하기에는 매우 부족했다.

Groq 모델 시도

다른 무료 모델을 찾다 보니 Groq의 무료 모델도 많이 추천하더라. 처음에는 일론 머스크의 x.ai Grok으로 생각했는데 다른 회사였다. Grok가 아닌 Groq다.

Groq에서는 무료 모델도 제공한다. 모델명 마지막에 :free라는 문구가 있으면 무료로 사용할 수 있는 모델이라고 한다. 아예 제약이 없는 건 아니고 속도가 느리거나 약간의 제약은 있다고 한다.

하지만 Groq의 무료 모델은 사용해보지 못했다. 오픈클로 때문에 무료 모델 사용 요청이 급증하면서 제대로 무료 모델을 사용하기 힘든 상황으로 보였다.

무료 모델의 한계

무료 모델을 찾아 헤맸지만 뭔가 제대로 쓰기 힘든 상황이었다. 처음 시도한 Gemini 모델처럼 무료로 제공되는 사용량으로는 제대로 된 체험 시작도 못 해볼 정도였다.

이 모델 문제로 이틀 정도 시간을 낭비했다. 결국 OpenRouter라는 서비스에 가입하고 $10(약 15,000원)를 결제했다.

OpenRouter와 다양한 모델 테스트

OpenRouter는 다양한 모델을 사용할 수 있게 제공하는 서비스다. 현재 서비스되는 대부분의 LLM이 제공되고, 그중 사용할 모델을 선택하면 된다. 비용은 충전해놓은 Credits에서 차감되고, 다 소진되어도 일부 무료 모델을 쓸 수 있다고는 하는데 이제는 무료 모델은 기대하지 않는 상태다.

OpenRouter에서 충전해놓은 $10를 사용하면서 다양한 모델을 테스트해봤다. 사용해본 모델은 크게 Gemini, GPT, Kimi, DeepSeek, Claude다.

사용해본 모델들의 평가가 궁금하다면 아래 링크의 글 참고

OpenRouter 모델 가성비 비교 – 오픈클로 에이전트 작업 적합 모델 찾기

충전해놓은 돈을 최대한 오래 사용하고 싶어서 가성비 모델들을 찾아 사용해봤다. 그런데 결론은 명확했다. 저렴한 모델로는 오픈클로를 제대로 사용할 수 없다.

저성능 모델 vs 고성능 모델의 차이

저성능 모델의 문제점

비용이 저렴한 구 버전 모델이나 GPT 모델 중 ‘mini’ 이름이 붙은 모델, Gemini 구버전 모델은 일 처리를 제대로 못 한다.

요청한 작업에서 스크립트 에러가 나거나 예상 못 한 상황이 나타나면 에러 났다고 그냥 그만둔다. 또는 작업이 제대로 완료되지 않는다. 결국 내가 직접 해야 하는 일이 늘어나고 시간이 많이 소요되는데, 제대로 된 결과를 얻어내지 못한다.

실제 작업 과정의 예시를 들어보겠다.

저성능 모델과의 대화:

나: “10분 후에 OO 파일 작성하고 나에게 알려줘”

오픈클로: “알겠습니다.”

(10분 후 알림이 안 온다. 찾아보니 작성된 파일도 없다.)나: “작업 제대로 된 것 맞아?”

오픈클로: “작업이 정상 처리된 로그 확인했습니다.”나: “OO 파일 작성해봐”

오픈클로: “작성했습니다.”

(실제 파일은 작성되어 있다.)나: “그러면 지금 방식으로 10분 후에 파일 작성해서 나에게 알려줘”

오픈클로: “알겠습니다.”

(10분 후 알림이 와서 파일을 확인하면 명령할 때 이미 파일 작성을 완료하고 10분 후에 알림만 준 거다.)나: “10분 후에 파일 작성하고 알려달라고 했잖아. 지금 작성하지 말고 10분 후에 파일 작성하고 나에게 알림 줘.”

오픈클로: “알겠습니다.”

(10분 후에 작업했다고 알림은 왔으나 파일은 작성되어 있지 않다.)나: “알림은 왔는데, 파일은 없어. 뭐가 문제였는지 확인해봐”

오픈클로: “로그를 확인하니 요청한 작업은 오류 없이 정상 수행되었습니다.”

이런 패턴으로 계속 진행된다. 아침마다 그날 날씨 브리핑을 받는 작업을 시키려고 했는데, 이 작업을 만들기 위해 수십 번의 대화를 했지만 결국 제대로 만들어진 건 없었다.

고성능 모델의 위엄

반면 고성능 모델에게 시키면 일 처리는 이렇게 진행된다.

나: “10분 후에 OO 파일 작성하고 나에게 알려줘”

오픈클로: “알겠습니다.”

(10분 후)

오픈클로: “OO 파일 작성했습니다. 작성 중 이러이러한 오류가 발생했는데 이렇게 해서 문제 해결을 했고 요청한 파일 작성을 정상적으로 수행했습니다.”

사용해보니 이런 차이가 발생하더라. 물론 고성능 모델이 토큰 소모가 크다 보니 호출 비용이 많이 든다. 저성능 모델은 호출 비용이 저렴해서 부담 없이 이것저것 물어보고 시킬 수는 있지만 제대로 된 결과를 얻기 어렵다.

누군가의 비유

누가 이런 비유를 하더라. 고성능 모델은 전문가 1명에게 일을 맡기고 결과를 받는 것이고, 저성능 모델은 오늘 처음 온 알바들을 데리고 내가 직접 일해서 결과를 얻는 것이라고. 며칠간 저성능 모델들과 씨름하다 보니 완전히 공감하게 됐다.

깨달음과 방향 전환

저렴한 모델로 어떻게든 돈 안 들이고 사용하는 방법을 찾는 건 그만두기로 했다.

인터넷에 나와 비슷한 사례나 문제에 대한 해결 방법을 이리저리 뒤져봐도 결과가 안 나왔던 건, 다들 제대로 된 모델로 굴리고 있어서 나와 같은 이슈가 없었던 것이다.

유료 모델을 사용하기로 결심했지만, 그래도 가성비 모델을 찾기 위해 조금 더 고민했다.

가성비 모델 찾기

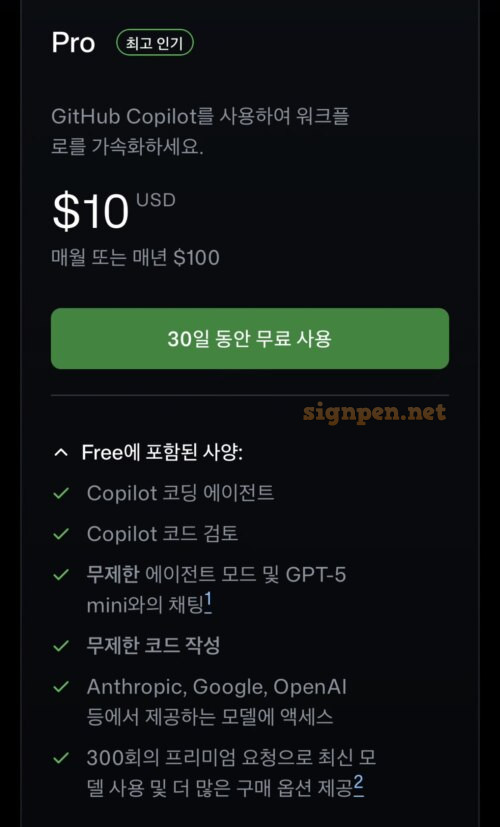

첫 번째 후보: GitHub Copilot

첫 번째 후보는 GitHub Copilot이었다. 매달 $10인 Pro 요금제를 사용하면 매월 300회의 프리미엄 모델 사용, 또는 GPT-4.1이나 GPT-4o mini 모델 무제한 사용이 가능하다.

프리미엄 모델 사용 횟수는 아쉬웠지만 GPT-4.1 정도 되는 모델을 무제한으로 사용할 수 있다는 게 매력적이었다.

하지만 막상 결제하려고 하니 내가 가입해둔 GitHub 계정이 장기 미사용으로 유료 결제를 할 수 없게 막혀 있는 상태였다. 이걸 해제하려고 메일을 보냈는데 연락이 없어서 다른 제품도 고민하게 되었다.

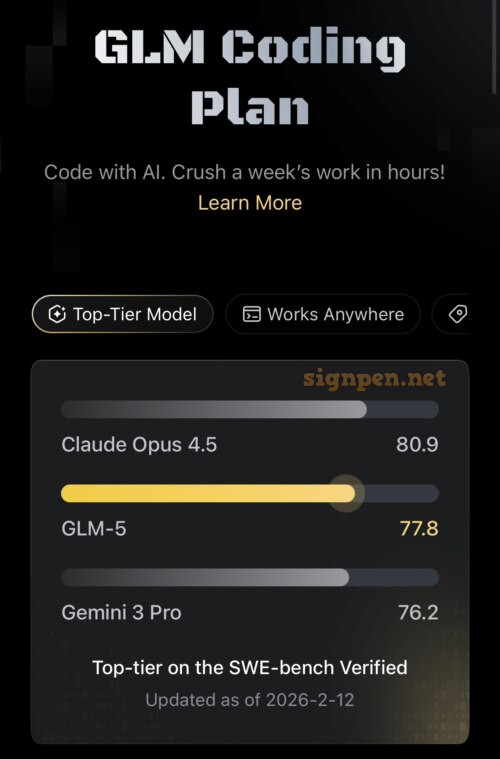

두 번째 후보이자 최종 선택: GLM-4.7

두 번째 후보가 지금 사용하고 있는 GLM-4.7 모델이다.

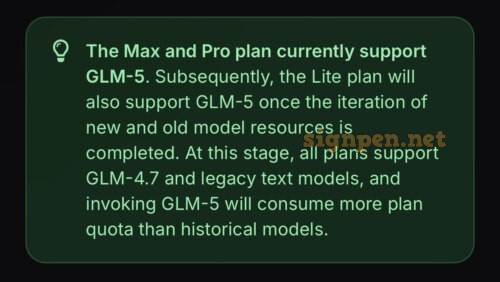

인터넷을 통해 찾아보니 z.ai에서 자사의 최신 모델인 GLM-5가 Claude Opus 4.5 모델과 Gemini 3 Pro 모델과 성능이 비슷하다고 홍보하고 있었다. 실제로도 괜찮다는 평가가 많았고, 구독 플랜 가격이 아주 저렴해서 관심이 갔다.

일단 OpenRouter에 남아 있는 Credits으로 GLM-4.6 모델을 연결해서 돌려봤다. 꽤 준수한 성능이 나왔고 만족스러웠다. 이 정도면 충분하다는 생각이 들었다.

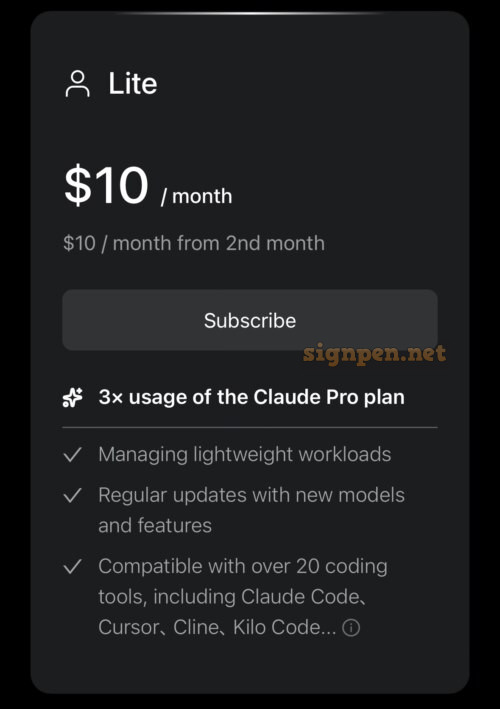

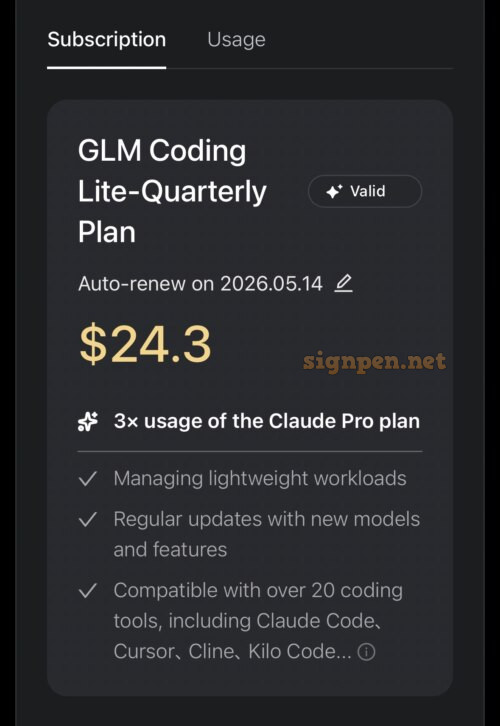

GLM 구독 플랜 가입

구독 모델을 가입하려고 찾다 보니 GLM Coding Lite 플랜이 가장 저렴한 상품인데 월 $6라는 정보가 있었다. 첫 구독은 50% 할인까지 들어가서 월 $3라는 글도 보였다. 이 정도로 가격이 저렴하면 50% 할인받아서 1년 구독을 결제해도 부담이 없겠다는 생각이 들었다.

하지만 실제 찾아보니 1달 구독 플랜은 $10로 가격이 표시되어 있었다. 1월까지는 월 $6에 50% 행사도 있었지만, 오픈클로로 인해 사용자가 늘어나면서 구독 플랜 가격을 인상했다고 한다.

구독 플랜은 5시간 단위로 모델 호출량 제한이 있고 5시간이 지나면 초기화된다고 한다. 제공해주는 호출 제한이 부족하지는 않았다.GitHub Copilot의 월 300회 프리미엄 모델 호출과 비교하면 훨씬 많은 제공량이다.

GitHub Copilot이 무제한 사용할 수 있는 모델을 제공해주는 것 처럼 GLM-4.7-Flash 라는 모델을 무제한으로 사용할 수 있게 제공해준다. 평소에는 무제한 모델로 사용하다가 어려운 작업을 시켜야 할 때만 GLM-4.7 모델로 변경해서 사용해도 된다.

중국 회사에 대한 우려

아무래도 z.ai라는 중국 회사에서 서비스하는 모델이라 이유 없는 불안감을 가질 수도 있다. 하지만 다른 회사들의 월 구독 플랜 가격과 비교하면 분명 고민이 될 수밖에 없는 가격이다.

현재 사용 중인 세팅

일단 나는 지금 z.ai의 GLM Coding Lite 플랜으로 구독을 시작했고, GLM-4.7 모델을 오픈클로의 두뇌로 사용하고 있다. 성능은 만족스럽다. OpenRouter로 테스트했던 GLM-4.6 정도만 되어도 쓸만했는데 그것보다 더 높은 버전이라서 그런지 일을 더 잘한다.

혹시 나처럼 무료 LLM을 찾아 헤매다 저렴한 비용으로 쓸 만한 LLM을 돌리는 것에 관심 있는 사람이 있다면 추천하고 싶다.

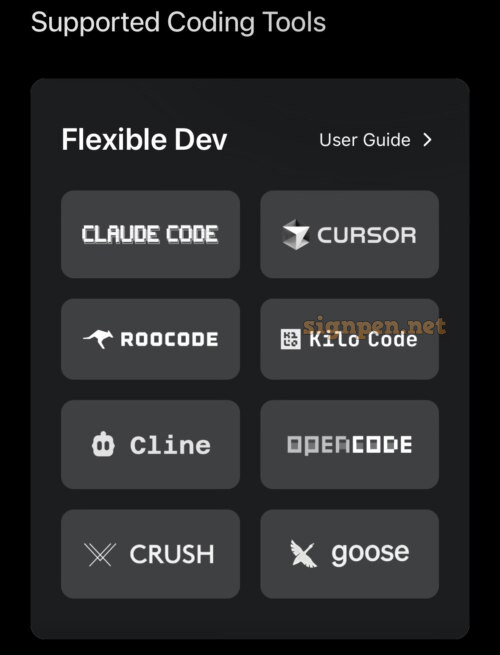

다른 도구에도 활용 가능

오픈클로뿐만 아니라 Claude Code, Open Code, Cursor 등 다른 도구들에도 내 구독 플랜 모델을 적용해서 사용할 수 있다.

그동안 비용이 비싸서 Claude Code에 관심은 있었지만 사용해보지 못하고 있었다. 대안으로 Gemini-CLI의 무료 제공량으로 어떤 건지 맛만 보고 있었다. 시간 날 때 Claude Code에 GLM 모델 구독 플랜을 연동해서 한번 사용해볼 계획이다.

마무리

오픈클로를 제대로 사용하려면 제대로 된 LLM 모델이 필수다. 무료 모델로 시작할 수는 있지만, 본격적으로 활용하려면 유료 모델을 고려해야 한다.

내 경험상 가성비 측면에서 z.ai의 GLM-4.7 모델이 현재로서는 최선의 선택이었다. 물론 각자의 사용 패턴과 예산에 따라 다른 선택이 더 나을 수도 있다.

z.ai사의 GLM 모뎅의 구독을 고려하고 있다면 아래 링크를 통해 결제하는걸 추천한다. 아래 링크를 통해 플랜에 가입하게 되면 10% 할인된 금액으로 플랜에 가입할 수 있다. 그리고 나에겐 약간의 리워드가 들어오게 된다. 나도 인터넷 누군가의 추천링크를 통해서 10% 할인된 금액으로 3개월 플랜에 가입했다.

이 글이 오픈클로 세팅으로 고민하는 누군가에게 작은 도움이 되길 바란다.

귀한 글 덕분에 많은 도움받고 있습니다.

저도 안그래도 고급 모델의 성능맛을 봤더니 코파일럿의 gpt4o나 gpt5mini는 뭔가 성능이 반쪽같아서

가성비 좀 괜찮으면서 저렴한 모델 뭐 없을까 찾다가 이 글도 찾게 되서

추천인코드 넣고 3개월 넣어봤습니다. ㅎ

혹시 glm 4.7 flash 모델 무제한 제공이 모델 선택할때 flashx 라고 되어있는 모델만 무제한인건가요? glm-4.7-flash로 선택하고 쓰니까 계속 자꾸 api 리미트가 뜨면서 대화가 끊어지는 경우가 생기네요.

z.ai의 코딩 플랜에 탑승하셨군요!

일단 모델 목록은 아래 문서를 참고하시면 좋을 것 같습니다.

https://docs.z.ai/guides/overview/pricing

무료 모델은 GLM-4.7-Flash, GLM-4.5-Flash 이렇게 두 가지이고요. GLM-4.7-FlashX 모델은 코딩플랜에서 사용할 수 없는 것 같아요. 저도 시도해봤는데 연결되지 않더라구요.

대신 이런저런 모델들을 다 시험해보니까 GLM-4.5-Air 모델은 사용 가능합니다. 무료는 아닌데 GLM-4.7 보다는 토큰 비용이 저렴한 모델이거든요. GLM-4.5-Air를 사용하면 5시간 사용가능한 쿼터제한에 사용량을 4.7모델보다 적게 소모한다고 합니다.

GLM-4.7-Flash 모델을 사용할 때 자꾸 api리미트가 뜨면서 끊어지는 경우는, 제 추측으로는 동시사용 제한 같은것에 걸리는게 아닌가 생각됩니다.

https://z.ai/manage-apikey/rate-limits#rate-limits

OpenClaw가 코드를 분석하거나 도구를 실행하면서 동시에 2~3개의 요청을 던지면 이런 제약에 걸려서 안될 수도 있거든요.

정말 도움이 많이 되었습니다! 제미나이하고 씨름만 했는데… 다른 모델도 몇개해보다 포기상태였는데 제가 하고싶었던 테스트를 다 해주셨네요.. 추천 링크로 Glm 가입했습니다 !

방문해주셔서 감사합니다!

Terry님도 LLM 모델로 씨름하셨군요. 저도 처음엔 무료로 해보려고 애썼는데, 결국 제대로 된 모델이 필요하다는 결론에 도달했습니다.

GLM-4.7 모델로 시작하신 것을 축하드립니다! 성능 만족스러우실 거예요. 사용하시다가 궁금한 점이나 설정에서 막히는 부분이 있으면 댓글로 남겨주세요. 아는 선에서 답변해 드리겠습니다.

오픈클로로 즐거운 AI 라이프 되시길 바랍니다!

처음 온보드 설정할때 z.ai auth method 항목을 coding-plan-global 선택하고 api 넣는거 맞죠?

이상하게 자꾸 api 리미트가 걸린다고 뜨네요 ㅠㅠ

네. 맞습니다.

coding-plan-global 선택해서 API 키를 입력하면 됩니다.

혹시 다른 모델들 설정해서 테스트하신게 있다면 다른 모델로 동작해서일수도 있고요.(설정을 확인해야 합니다)

openclaw.json에 모델명이 “zai/glm-4.7″ 또는 “zai/glm-4.7-flash” 형식의 이름으로 등록되어있는지 확인해보세요. 온보드 기능에서 모델을 선택해서 넣었다면 모델명 문제는 아닐것 같은데요. 그래도 잘 등록되어 있는지 점검이 필요할 것 같습니다.

{

“meta”: {

“lastTouchedVersion”: “2026.3.2”,

“lastTouchedAt”: “2026-03-05T06:24:31.783Z”

},

“wizard”: {

“lastRunAt”: “2026-03-05T06:24:31.755Z”,

“lastRunVersion”: “2026.3.2”,

“lastRunCommand”: “onboard”,

“lastRunMode”: “local”

},

“auth”: {

“profiles”: {

“github-copilot:github”: {

“provider”: “github-copilot”,

“mode”: “token”

},

“google:default”: {

“provider”: “google”,

“mode”: “api_key”

},

“openai-codex:default”: {

“provider”: “openai-codex”,

“mode”: “oauth”

},

“zai:default”: {

“provider”: “zai”,

“mode”: “api_key”

}

}

},

“models”: {

“mode”: “merge”,

“providers”: {

“zai”: {

“baseUrl”: “https://api.z.ai/api/coding/paas/v4”,

“api”: “openai-completions”,

“models”: [

{

“id”: “glm-5”,

“name”: “GLM-5”,

“reasoning”: true,

“input”: [

“text”

],

“cost”: {

“input”: 0,

“output”: 0,

“cacheRead”: 0,

“cacheWrite”: 0

},

“contextWindow”: 204800,

“maxTokens”: 131072

},

{

“id”: “glm-4.7”,

“name”: “GLM-4.7”,

“reasoning”: true,

“input”: [

“text”

],

“cost”: {

“input”: 0,

“output”: 0,

“cacheRead”: 0,

“cacheWrite”: 0

},

“contextWindow”: 204800,

“maxTokens”: 131072

},

{

“id”: “glm-4.7-flash”,

“name”: “GLM-4.7 Flash”,

“reasoning”: true,

“input”: [

“text”

],

“cost”: {

“input”: 0,

“output”: 0,

“cacheRead”: 0,

“cacheWrite”: 0

},

“contextWindow”: 204800,

“maxTokens”: 131072

},

{

“id”: “glm-4.7-flashx”,

“name”: “GLM-4.7 FlashX”,

“reasoning”: true,

“input”: [

“text”

],

“cost”: {

“input”: 0,

“output”: 0,

“cacheRead”: 0,

“cacheWrite”: 0

},

“contextWindow”: 204800,

“maxTokens”: 131072

}

]

}

}

},

“agents”: {

“defaults”: {

“model”: {

“primary”: “zai/glm-4.7-flash”,

“fallbacks”: []

},

“models”: {

“anthropic/github-copilot:gpt-5-mini”: {},

“github-copilot/gpt-4o”: {},

“github-copilot/gpt-5-mini”: {},

“google/gemini-3.1-pro-preview”: {},

“openai-codex/gpt-5.3-codex”: {},

“openai-codex/gpt-5.2-codex”: {},

“zai/glm-5”: {

“alias”: “GLM”

},

“zai/glm-4.7-flash”: {},

“zai/glm-4.7-flashx”: {},

“zai/glm-4.7”: {},

“google/gemini-3-pro-preview”: {}

},

“workspace”: “/Users/dei/.openclaw/workspace”,

“sandbox”: {

“browser”: {

“allowHostControl”: true

}

}

}

},

openclaw.json 설정 파일 일부인데 틀린 부분이 있는지 한번 봐주실수 있을까요.

분명 온보딩으로 api값도 잘 넣었는데 게이트웨이 재시작하고 모델 상태를 물어보면

자꾸 glm 모델 로딩이 안되고 기존 제미나이나 코파일럿 모델이 세팅되어있어서

glm4.7-flash로 바꿔달라고 하면 권한이 없다고 뜹니다 ㅠㅠ

/*

GLM-4.7 Flash 모델로 변경 시도를 했지만, 여전히 허용되지 않는 상태입니다.

권한 설정이나 모델 정책을 추가로 검토해야 할 것 같습니다. 필요한 작업이나 다음 단계가 있다면 알려주세요!

*/

“primary”: “zai/glm-4.7-flash”

써주신 내용으로 보면 glm 모델로 잘 설정되어 있는 것 같습니다.

“/status” 명령어로 현재 모델이 어떤 것으로 로딩되어 있는지 확인해보세요. glm 모델로 되어있는지요.

만약에 다른 모델이라면 수동으로 모델 변경이 가능합니다.

“/model zai/glm-4.7-flash” 명령어로 모델 변경이 가능한데요. 혹시 모르니 “/model zai/glm-4.7” 명령어로 4.7 모델로 변경 후 작동하는지 확인하시고 잘 작동하면 다른 모델들을 테스트해보면 될 것 같습니다.