오픈클로에 사용할 가성비 모델을 찾기 위해 나름 다양한 모델을 직접 테스트해봤다. 이 글은 그 과정에서 얻은 결과를 정리한 기록이다.

오픈클로(Openclaw) LLM 모델 선택 가이드 – 무료부터 유료까지 실제 사용 후기

이전 글에서 무료 모델의 한계를 느끼고 OpenRouter에 $10를 충전해서 여러 모델을 테스트한 이야기를 썼다. 이 글은 그 과정에서 테스트한 모델들의 상세 후기다. 여기저기 검색해봐도 이런 모델 사용 경험에 대한 정보는 찾기 어려웠다. 이 삽질 기록이 다른 누군가에겐 도움이 되길 바란다.

목차

테스트 기준: 오픈클로에 적합한 LLM의 조건

본격적인 모델 비교에 앞서, 오픈클로 에이전트 작업에 적합한 LLM이 갖춰야 할 능력을 먼저 정리하고 넘어가겠다.

A. 의도 분해 정확도 — 명령을 구조화된 액션으로 변환하는 능력. 시간 표현, 조건문, 후속 행동을 정확하게 인식하는 것.

B. 상태 인식 능력 — 현재 시점과 미래 시점을 구분하고, 이미 실행했는지 여부를 스스로 판단하는 능력.

C. 툴 선택 정확도 — 지금 실행해야 할지, 예약 툴을 써야 할지, 외부 API를 호출해야 할지 올바른 툴을 선택하는 능력.

D. 툴 사용 안정성 — JSON 포맷이 깨지지 않고, 잘못된 파라미터를 넣지 않으며, 재시도 전략이 있는 것.

이 능력들이 부족하면 “내일 아침에 날씨 알려줘”라는 명령에 ‘내일 아침에’라는 표현을 예약 작업으로 인식하지 못하고 즉시 날씨 정보를 불러오는 방식으로 동작한다. 의도를 이해하는 능력도 중요하지만, 결국 툴 사용 능력이 핵심이다.

테스트에 사용한 작업

모든 모델에 동일한 작업을 시켰다. 매일 아침 특정 시간에 오늘 날씨를 브리핑하는 작업이었다. 현재 온도, 최저/최고 온도, 강수 확률과 함께 우산을 챙겨야 할지, 옷을 두껍게 입어야 할지 판단해서 알려주는 것이었다.

테스트 결과: 부적합 모델

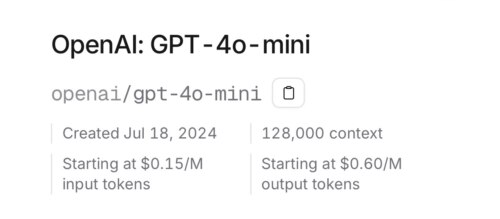

OpenAI: GPT-4o mini

$0.15/M input tokens, $0.60/M output tokens

토큰 비용이 매우 저렴하다. 한참 대화하고 일을 시켜도 크레딧 소모가 적다. 하지만 완료된 작업도 없다. 비용 대비 결과가 없으니 사실상 의미가 없는 모델이었다.

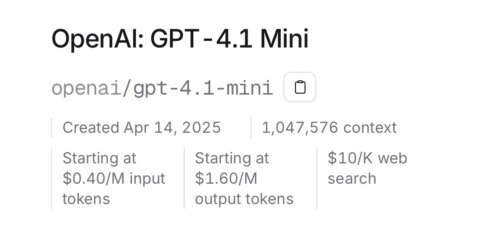

OpenAI: GPT-4.1 Mini

$0.40/M input tokens, $1.60/M output tokens

GPT-4o가 더 최신 모델이라고 들었는데, 실제로 사용해보니 Mini가 붙은 4.1 Mini가 일을 더 잘 처리했다. 잠깐은 이걸 주력 모델로 사용할까 생각했다. 그런데 시키는 일이 조금만 복잡해져도 한 번에 처리가 잘 되지 않아서 아쉬움이 남았다.

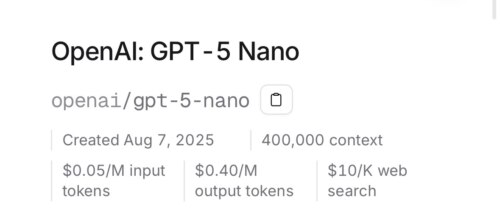

OpenAI: GPT-5 Nano

$0.05/M input tokens, $0.40/M output tokens

최신 모델은 GPT-5 이름을 달고 있어서 기대했지만 Nano라서 성능이 많이 낮다. 토큰 비용도 싸지만 그만큼 결과도 아쉬웠다.

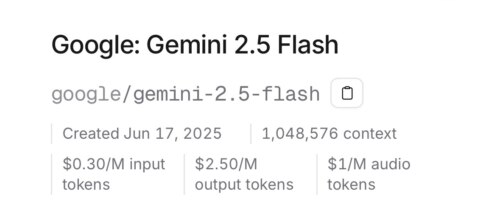

Google: Gemini 2.5 Flash

$0.30/M input tokens, $2.50/M output tokens

많이 사용해보지는 않았다. 토큰 비용이 아주 싸지는 않다. Gemini 모델은 3 버전부터 원활하게 사용 가능하다는 느낌이었다. 충분히 체험해보지 못해서 평가하기 애매한 모델이다.

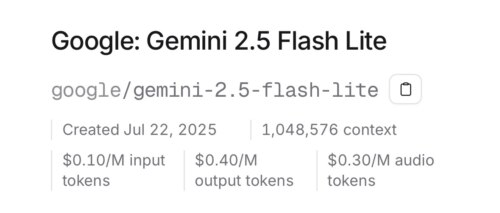

Google: Gemini 2.5 Flash Lite

$0.10/M input tokens, $0.40/M output tokens

모델명에 Lite가 붙으면서 토큰 가격이 매우 저렴해진다. 하지만 성능도 함께 낮아진다. 가격과 성능이 정직하게 비례하는 케이스였다.

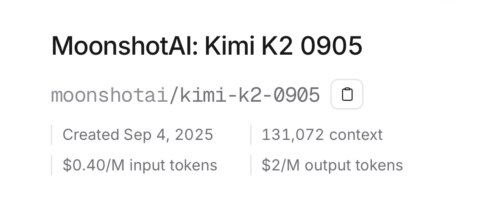

MoonshotAI: Kimi K2 0905

$0.40/M input tokens, $2/M output tokens

Kimi라는 모델은 처음 들었다. 토큰 비용이 비싼 편이라 최신 모델 대신 이 버전을 먼저 사용해봤다. 잠깐 사용해봤는데 인상적인 기억은 없었다. GPT-4.1 Mini와 비슷한 정도의 인상이었다. 인터넷에서 Kimi가 가성비로 추천되는 글들을 봤는데, 이때는 왜 추천받는 모델인지 전혀 이해하지 못했다. 나중에 이유를 알게 됐다. 이유는 적합 모델 항목에서 설명하겠다.

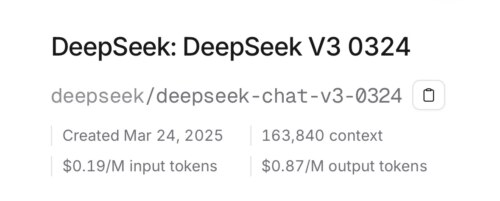

DeepSeek: DeepSeek V3 0324

$0.19/M input tokens, $0.87/M output tokens

딥시크도 가성비로 많이 추천하길래 사용해봤다. 최신 버전이 아닌 조금 낮은 버전을 사용했다. 내가 사용한 모델은 정말 별로였다. 아마도 최신 버전이었다면 평가가 달랐을 수 있다. 대신 토큰 비용도 더 비쌌겠지.

테스트 결과: 적합 모델

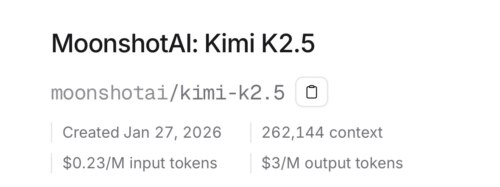

MoonshotAI: Kimi K2.5

$0.23/M input tokens, $3/M output tokens

이 모델을 써보고 나서야 왜 Kimi 모델을 추천하는지 이해했다. 꽤 쓸 만했다. 내가 최종적으로 정착할 모델이 될 뻔했으나, 월 정액 플랜 가격이 $19여서 가성비를 찾는 나에게는 조금 비쌌다.

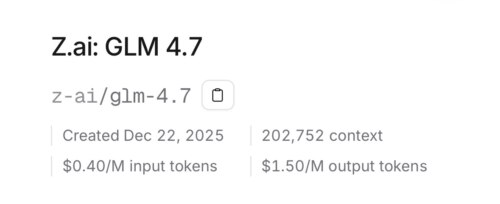

Z.ai: GLM-4.7 ⭐ 최종 선택

$0.40/M input tokens, $1.50/M output tokens

내가 최종적으로 정착한 모델이다. 월 정액 플랜 가격이 $10으로 가성비도 납득할 만한 수준이다.

며칠째 사용 중인데 이 정도면 충분하다고 생각한다. 가성비 모델들이 처리하지 못해서 시간을 낭비했던 작업들을 이 모델로 다 처리했다. GLM Coding Lite 플랜의 쿼터 제한을 조금 신경 쓰면서 사용해야 한다. 나는 Lite 플랜으로도 충분하지만, 본격적으로 빡세게 일을 시키려면 더 높은 플랜도 고려해볼 만하다.

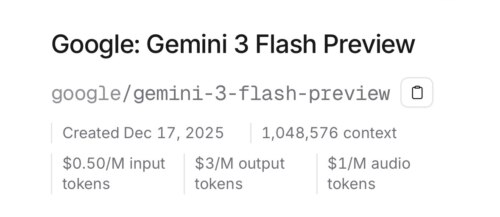

Google: Gemini 3 Flash Preview

$0.50/M input tokens, $3/M output tokens

처음에 잠깐 무료로 사용해본 모델이라 제대로 된 평가가 어렵다. 웹에서 검색된 내용을 보면 이 모델이면 성능이 충분하다는 이야기가 많다.

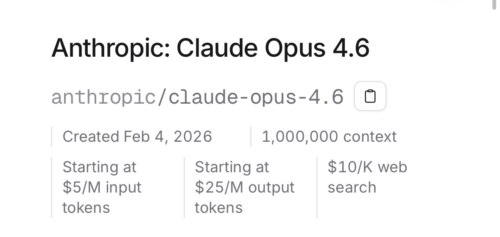

Anthropic: Claude Opus 4.5 👑 성능 최강

$5/M input tokens, $25/M output tokens

이건 정말 최종 보스다. 내가 사용해본 모델들 중 토큰 비용이 가장 비싸고, 성능도 가장 월등하다.

원래는 이 모델을 사용해볼 생각이 없었다. GLM-4.7을 유료로 결제하면서 OpenRouter에 남아있는 크레딧을 소진하기 위해 폴백 모델로 OpenRouter auto를 등록해뒀는데, 설정이 잘못되어 GLM-4.7이 아닌 이 모델이 자동으로 사용되고 있었다.

얘가 일하는 줄도 모르고, GLM-4.7이 엄청나게 좋다고 착각했다. 그동안 가성비 모델들과 씨름하다가 드디어 제대로 된 모델을 만난 것 같아서 모든 고민이 날아가는 느낌이었다. 나중에 확인해보니 OpenRouter에 아껴서 사용하던 크레딧이 이 모델 몇 시간 사용하고 $6나 소모되어 있었다.

모델 사용에 금전적인 여유만 있다면 이 모델이 최고라고 생각한다.

모델 성능이 실제로 어떻게 다를까

한 가지 사례를 더 소개하겠다. 부적합으로 분류한 모델에게 기상청 API를 활용해서 날씨 조회하는 기능을 스킬로 등록해달라고 했다. 그랬더니 weather_skill.js 파일만 덩그러니 만들어두고 스킬을 만들어서 등록했다고 보고했다.

나중에 적합 모델로 분류한 모델에게 이미 날씨 조회 스킬이 만들어져 있다고 알려줬더니, 그걸 직접 오픈클로 문서를 뒤져서 고치기 시작했다. SKILL.md도 만들고, 필요한 파일들을 추가로 만들어서 정식 스킬 형식으로 등록까지 완료해줬다. 기존에 있던 건 스킬 형식에 맞지 않는다면서 혼자 알아서 작업을 해뒀다.

이때부터 고성능 모델의 필요성을 더욱 절실하게 느꼈다.

맥미니 로컬 LLM, 현실적으로 가능할까?

맥미니에 로컬 LLM을 돌리는 것을 꿈꾸는 사람들을 위해 정리해봤다. 나도 정확하게 알 수는 없어서 GPT에게 물어봐서 가능한 모델 목록을 뽑았다. 각 모델의 토큰 비용으로 어느 정도 성능을 가늠해볼 수 있다.

전제는 Apple Silicon 맥미니, llama.cpp나 Ollama로 구동하는 경우다.

맥미니 8GB 메모리 모델

현실적으로는 7B 이하 모델이 한계다. 양자화도 필수다. 모델을 돌리면서 에이전트가 동시에 작업하려면 매우 빡빡하다.

| 모델 | 비교 가능한 API 모델 | Input | Output |

|---|---|---|---|

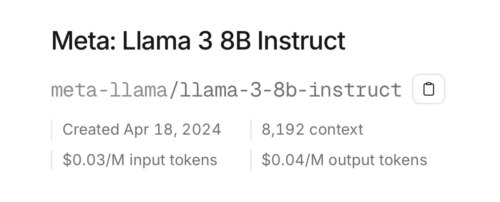

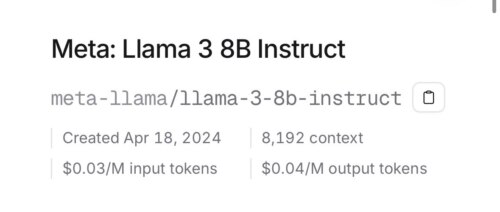

| Llama 2 7B (q4) | Meta: Llama 3 8B Instruct | $0.03/M | $0.04/M |

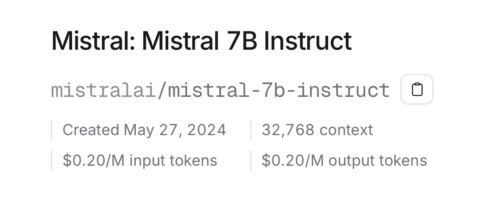

| Mistral 7B (q4) | Mistral: Mistral 7B Instruct | $0.20/M | $0.20/M |

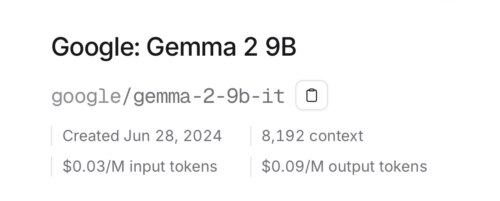

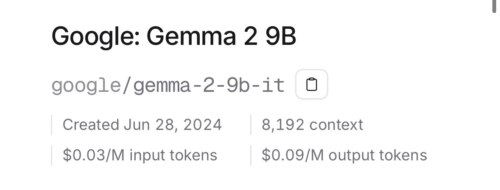

| Gemma 2B/7B | Google: Gemma 2 9B | $0.03/M | $0.09/M |

OpenRouter에 해당하는 모델이 없어서 비교가 될만한 모델들을 골라서 비교해봤다. 비교 가능하다고 했지만 맥미니에서 구동하는 모델은 양자화로 용량이 많이 줄어든 모델이다. 성능은 비교 가능 모델보다 많이 낮다고 생각하면 될 것 같다.

맥미니 16GB 메모리 모델

여기서부터는 조금 낫다. 모델과 에이전트를 함께 구동하는데 조금은 나은 상황이다.

| 모델 | 비교 가능한 API 모델 | Input | Output |

|---|---|---|---|

| Mistral 7B (q4~q8) | Mistral: Mistral 7B Instruct | $0.20/M | $0.20/M |

| Llama 2 13B (q4) | Meta: Llama 3 8B Instruct | $0.03/M | $0.04/M |

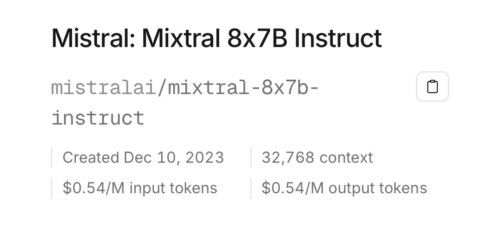

| Mixtral 8x7B (q4, 매우 빡빡) | Mistral: Mixtral 8x7B Instruct | $0.54/M | $0.54/M |

| Gemma 7B | Google: Gemma 2 9B | $0.03/M | $0.09/M |

비교 모델이라고 쓰긴 했지만 사실은 비교 모델을 더 상위 모델로 보는 것이 맞을 것 같다.

결론

맥미니에서 구동 가능한 모델들을 보면, 내가 부적합으로 분류한 GPT-4o mini보다도 한참 낮은 성능의 모델들만 구동이 가능하다. 토큰 비용이 절대적인 성능 지표는 아니지만 대략적인 성능은 가늠해볼 수 있다.

맥미니 로컬 LLM으로는 작업이 조금만 복잡해져도 제대로 수행하지 못할 가능성이 높다. 그냥 대화 정도만 가능한 수준이라면, 오픈클로를 사용하는 의미가 없다. 32GB 모델부터는 조금 쓸 만한 모델을 돌릴 수 있을지도 모르겠다. 그래도 내가 적합 모델로 분류한 모델보다는 훨씬 낮은 성능일 것으로 생각한다.

마무리

일주일 정도의 시간을 모델 테스트에 쏟아부었다. 가성비 모델 찾느라 정작 오픈클로로 뭔가 제대로 일을 시켜본 건 별로 없다는 게 아이러니하다.

정리하자면 이렇다. 오픈클로를 쓰려면 적어도 Kimi K2.5 또는 GLM-4.7 수준의 모델은 사용해야 제대로 된 결과를 기대할 수 있다. 최고의 성능을 원한다면 Claude Opus 4.5가 답이지만, 비용 부담이 크다.

가성비와 성능 사이의 균형점에서 내가 선택한 건 GLM-4.7이었다. 각자의 사용 패턴과 예산에 따라 최선의 선택은 다를 수 있다. 이 글이 모델 선택에 고민하는 누군가에게 작은 참고가 되길 바란다.

좋은글 정말 잘 읽었습니다. ㅋㅋ 저도 Mac mini꿈꾸고 있었는데 당장 포기해야겠군요.

방문해주셔서 감사합니다! ㅎㅎ 맥미니 로컬 LLM은 아쉽지만 32GB 이상 모델을 노려보시면 조금 더 희망이 있을지도 모르겠어요. 그래도 API 사용이 요금제에 따라 더 경제적일 수 있으니 참고가 되셨다면 다행입니다!