signpen.net이라는 도메인을 소유하고 사용하면서 몇 가지 고민 아닌 고민이 있었다. 지금은 signpen.net이라는 도메인 하나만을 사용하고 있지만 얼마 전까지만 해도 signpen.pe.kr 도메인도 함께 소유하고 사용하고 있었다. 두 개의 도메인을 소유하고 있는 동안엔 net과 pe.kr 두 개의 도메인 모두 한 개의 서버로 접속이 되도록 설정하고 사용해 왔었다. 그런데 유독 signpen.net이라는 주소는 구글검색에 노출되지 않았었다. 당시엔 signpen.pe.kr 도메인을 먼저 사용했었고 중복되는 내용이 두 개의 주소에서 검출이 되니까 중복목록으로 들어가서 net 도메인의 주소가 노출되지 않는 것으로 생각했었다. 그런데 pe.kr 도메인의 사용 기간이 만료되어서 사용되지 않는 지금, 아직도 구글검색에선 signpen.net이라는 도메인이 검색 결과에 노출되지 않고 있다.

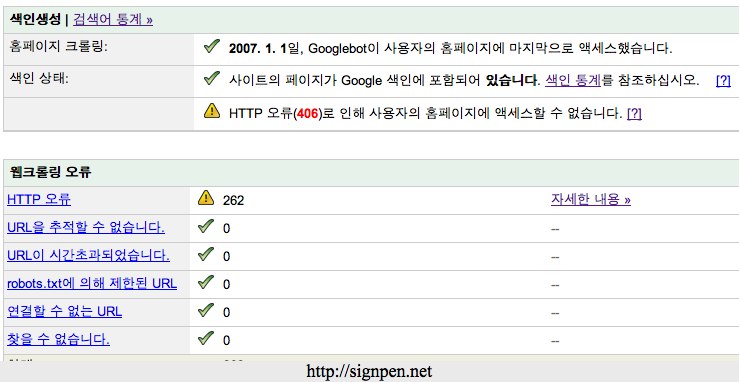

그동안 내 블로그는 오류투성이에다가 구글봇은 07년 신정을 마지막으로 발길을 끊어버렸다.

아무래도 signpen.net이라는 도메인의 전 소유주가 이 도메인을 이용해서 불법적인 행위를 해서 구글검색에서 제외된 도메인일 것이라는 판단이 들어서 구글사이트맵을 이용해서 새로 소유하게 된 도메인이라는 내용의 글과 함께 재등록 요청을 보냈다. 그로부터 이틀 후 구글 색인에 내 도메인이 포함되었다. 그러나 여전히 검색에는 노출되지 않고 있다. 구글사이트맵 서비스에도 ‘HTTP 406 에러’라면서 구글봇이 내 사이트에 접속되지 않는 것으로 나오고 있다. 어째서일까 라는 생각이 들어서 관련될만한 키워드로 구글링을 해 보았다.

목차

#modsecurity

몇 시간 동안 구글을 뒤져본 결과 내가 사용하고 있는 ‘웹제로‘라는 호스팅 업체의 문제로 결론이 나왔다. 웹 제로에서는 modsecurity 라는 보안에 관련된 아파치 모듈을 사용해 서버 레벨에서 모든 검색 로봇을 차단하고 있었던 것이었다. 구글봇 뿐만 아니라 야후봇, 네이버봇 모두 차단목록에 포함되어 있었다. 어쩐지 07년1월1일을 마지막으로 구글봇이 내 블로그에 들어오질 않고 있더라. ‘자주 먹통이 되곤 하지만 저렴해서 마음에 들었던 호스팅 회사였는데 결국 서버를 옮겨야 하나’라는 고민을 하고 있을 즈음에 간단하게 .htaccess파일 수정으로 해당 모듈을 사용하지 않는 방법을 찾아낼 수 있었다.

간단하게 계정에 있는 .htaccess파일에 3줄만 추가해주면 완료가 된다. 추가해야 할 내용은 아래와 같다.

SecFilterEngine Off

SecFilterScanPOST Off

SecFilterCheckURLEncoding Off

내용을 보면 알 수 있듯이 해당 모듈을 모두 off 시켜버리는 것이다. 아파치 서버를 사용하고 있지만 .htaccess파일이 생성되어있지 않다면 파일을 생성하고 위의 문장을 넣어주면 되고, 태터툴즈 유저의 경우엔 최상위 디렉터리에 존재하는 .htaccess파일을 찾아내서 맨 윗줄에 위에 있는 세 문장을 넣어주면 된다. .htaccess파일은 기본적으로 hidden 파일이므로 ftp 프로그램의 옵션을 통해서 숨겨진 파일을 보여주도록 설정하면 나타난다.

이렇게 설정을 넣어주고 나니까 일단은 잘 작동하는 것 같다. 검색에 노출되는 것은 며칠 기다려봐야 알 수 있으니 잠시 기다려봐야겠다. 예전엔 구글검색이나 야후검색, MSN검색을 통해서 내 블로그에 방문하는 숫자도 꽤 되었었는데 갑작스레 줄어들어서 무슨 일인가 의아해했었는데 이제야 문제를 알아내고 해결하게 되었다.

서버 레벨에서 이런 차단옵션을 만들어 두었으니 내 블로그의 평균트래픽이 이전의 호스팅을 이용할 때와 비교가 될 정도로 낮은 게 당연한 법. 덕분에 올블로그나 이올린이 아니고선 내 블로그는 인터넷이라는 방대한 공간 속에서 마치 무인도처럼 고립되어 있었다. 그나마 올블로그와 네이버의 협력 때문에 내 블로그의 글이 예전보다는 네이버에 많이 노출되었지만. 대신 ‘싸인펜’이라는 검색어로 구글 운 좋은 예감을 통해 내 블로그에 한 번에 접속되는 기분좋은 일과는 무척 거리가 멀어져버렸다. 구글검색을 통해서 내 블로그에 방문하는 사람의 숫자는 0이 되고 MSN이나 야후를 통한 방문도 거의 없다시피 했다.

#robots.txt

나처럼 블로그가 여러 가지 검색을 통해 노출되길 원하는 사람도 있겠지만 분명 그렇지 않을 사람들도 많을 것이다. 검색 로봇이 크롤링해가면서 발생하는 트래픽이 부담스러운 사람도 있을 것이고….

보통 검색봇을 차단하기 위해서 robots.txt파일을 생성해서 이용하는 방법이 있는데 태터툴즈 블로그에선 파일을 생성해서 내용물을 넣고 서버에 올린다고 해선 제대로 작동이 되질 않는 것 같다. 단적인 예로 robots.txt파일을 최상위 디렉터리에 업로드 했는데 ‘블로그 주소/robot.txt’로 접속을 하면 페이지를 표시할 수 없다는 에러 메시지만 나타나는 경우를 봐선 말이다. 내가 알기론 분명 robots.txt파일의 내용이 브라우저에 표시가 되어야 하는데 말이다.

그것은 태터툴즈 설치 시 자동으로 생성되는 .htaccess의 내용물 때문인데 기존에 있던 파일에 한 줄의 문구만 써 준다면 해결이 된다.

RewriteRule ^robots\.txt$ blog/robots.txt [E=SURI:1,L]

이런 방식으로 말이다. 뒤에 blog/robots.txt는 텍스트 파일이 실제 업로드되어있는 경로이고 앞의 내용은 ‘블로그 주소/robots.txt’ 형식으로 블로그에 접속을 했을 때 실제 파일이 있는 위치로 연결을 해 주는 것이다.

이렇게 해 두면 태터툴즈의 경우에도 ‘블로그 주소/robots.txt’라고 주소창에 입력하면 업로드한 robots.txt의 내용물이 웹브라우저에 표시가 된다. 종종 블로그에 robots 파일을 만들어서 업로드 해 두었는데 크롤러들이 규정을 무시하고 크롤링해 간다는 글을 본 적이 있었다. 태터툴즈의 경우라면 아마도 .htaccess파일을 손봐두지 않아서 그런 것이 아닌가 추측이 된다.

여러가지 노가다를 통해서 블로그를 새롭게(?) 셋팅 했다. 아.. 상쾌허다~S

아니 왜, 호스팅 업체 차원에서 검색을 막는거죠?

그러면 인터넷이라는 열린 공간안에 블로그나 홈페이지를 만드는 의미가 없지 않나요?

어쨌거나 저는 다른 블로거님들 덕분에 많이 배웁니다. 다행이라고 해야 하나요. 아직은 제 블로그 서비스하는 호스팅 업체는 그런 짓(?)을 안하나 봅니다. 휴우~~ 다행이다.

보안을 위해서 아파치에 모듈을 추가한 것 같은데, 알려진 검색로봇 정도는 차단리스트에서 제외를 해 주어야 하지 않았을까 하는 생각이 들어요.

저도 이런 경우가 있다는걸 처음 알았습니다…;;

전 그방법을 몰라서.. ( 운영자님께서도 방법을 모른다고만;;; )

호스팅 업체를 옮겼습니다 ^^; 아까워라.. ㅜㅜ

그리고 무엇보다 옮긴 이유는 페이지랭크의 0 추락이었습니다 ^^

사실 검색을 하면서 Ohyung님의 블로그에 웹제로 관련글을 보고나서 호스팅 자체에서 검색봇을 차단하고 있었다는걸 알게 되었습니다^^ㅋ

저도 지금은 페이지랭크가 0인데, 제가 쓴게 효과가 있다면 좋겠습니다. 확인해보니 검색로봇이 들락날락하기는 하고있습니다^^

저도 예전 24시간동안 문을 여는 카페(눈치채셨을듯)라는 호스팅을 썼었습니다. 초저가형 서비스를 써서 그런지 고객서비스도 불량이고, 마인드도 수준이하더군요..특히나 고객센터에 전화하면 왠 남자분이 걸걸한 목소리로 전화받으셨다는..쿨럭;;

24시간 카페는 일반 호스팅 외에도 쇼핑몰 호스팅, 기업사이트 호스팅 등 많은분야의 업무를 하고있는걸로 알고있습니다. 아마 그래서 고객서비스가 좀 떨어지지 않았나 싶습니다. 아무래도 상대해야하는 고객의 숫자가 많다보니 작은부분까지는 제대로 신경쓰지 못하는게 아닌가 생각이 드네요.

그렇지만 고객센터의 목소리 걸걸한 남자상담원은 24시간 카페가 실수를 한것 같네요. 저라도 별바람님과 같은 반응이…. 쿨럭;;

저는 24시간 문여는 카페 상담원 분들 참친절하다고 생각했었는데..다른분들은 아닌가봐요..ㄷㄷ

사실 전 24시간 회사를 이용해 본적은 없는데, 아마 그렇지 않을까 하는 생각에 댓글을 달아봤습니다.

목소리 걸걸한 남자상담원이라니…. 너무 끔찍해요..ㅠㅠ

저도 항상 봇 때문에 고민이었는데, 다행히 플러그인으로 상당부분 커버가 됩니다.

2-3개 정도의 플러그인을 사용하면서 나름 만족하고 있습니다.

저같은 비인기 블로그의 경우, 봇님께서 힛수 올려주시는 건 감사할 일인데

문제는 비인간적인 트랙백 횡포……. ^^;

그렇죠^^ 로봇님들이 저를 대신해 웹에 PR해 주는 것 까지는 좋은데, 가끔 무시무시한 일을 저지르는 것을 돕는 경우가 있어서말이죠^^ㅋ

제 블로그에 단 Ohyung님 댓글보고 왔습니다.

저는 이미 다른 곳으로 옮겼습니다만 (고객 센터 응대가 맘에 안 들어서리…)

.htaccess에는 아래 라인만 적어도 차단이 안 됩니다.

SecFilterInheritance Off

역시 싼게 비지떡인지라 예전에 사용하던 호스팅에 비해서 안정적이지 못한 느낌을 많이 받아요. DB에 접속을 할 수 없는 현상도 종종 있구요.

댓글정보 감사합니다^^ㅋ

아~ 드디어 이걸 알았네요 ㅎㅎ

저도 웹제로 ㄷㄷㄷ

제가 크롤이 안된다는걸 알고,

웹제로 고객센터에 막~ 머라머라머라 크롤을 이렇게막아도 되느냐~ 했더니

modsecurity 봇차단을 해제하셨답니다

그래도 sitemap등록시에는 계속 406오류가 뜨더군요

아놔~ 또 이렇다고말했더니

이건 서버문제가 아니라 제문제라고 하셔서 또-.-아놔 ㅎㅎ

406으로 구글링하다가 이포스트를 드디어보게됬네요ㅋ

덕분에 사이트맵 무사히등록했어요 ㅎㅎ 감사~

축하드립니다^^ 이제 검색 크롤러들도 다녀가고 검색을 통해서도 yello님의 글을 만날 수 있게 되었군요!!ㅎㅎ